#2. Наблюдаемость данных, государство - это формы, как учёные работают с данными

Несмотря на моё желание писать большие тексты с рефлексией на профессиональные темы лишь раз в месяц, но получается чаще. Скорее к радости, чем к сожалению, больше тем для размышления в последнее время.

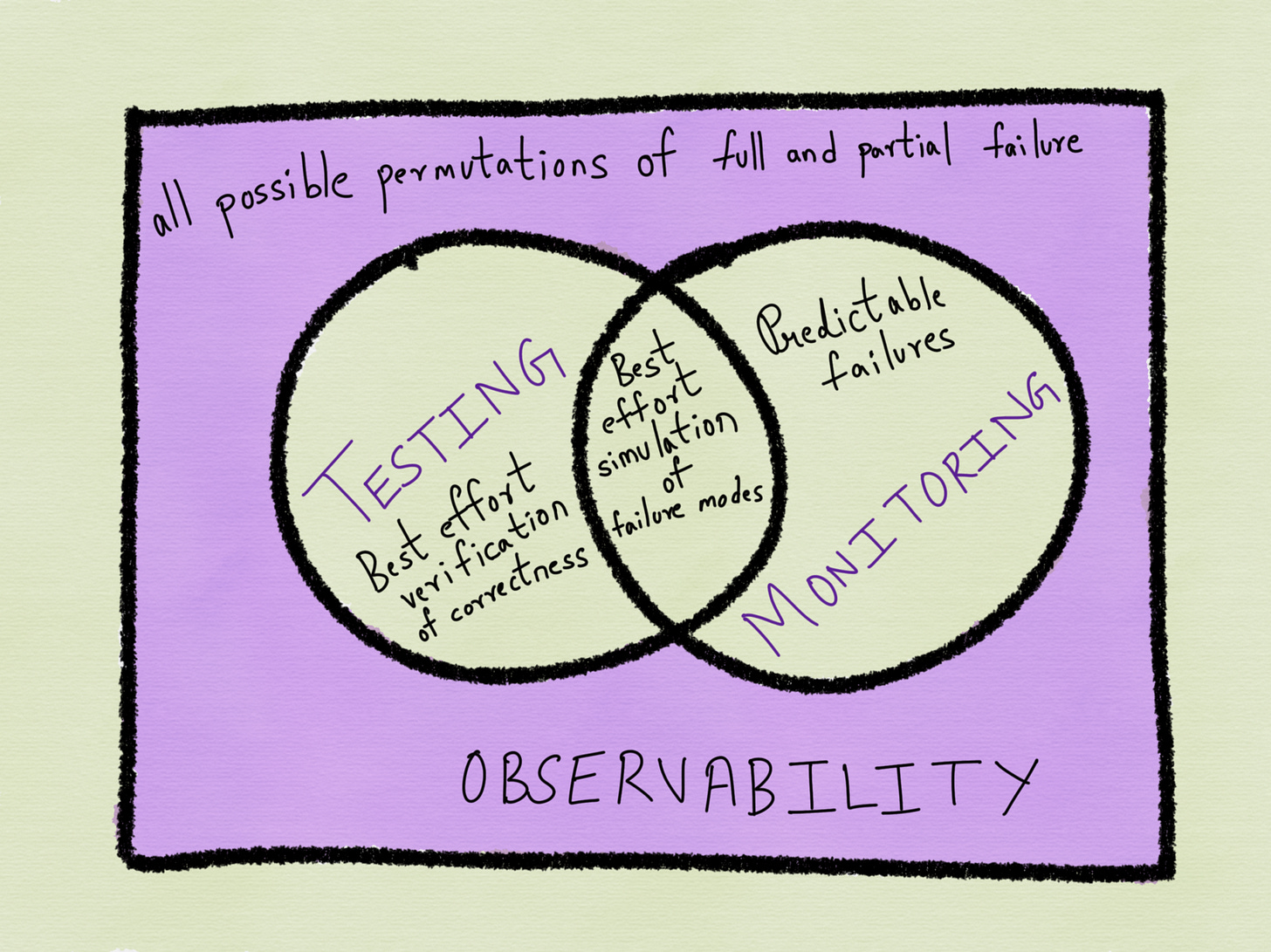

Data Observability

Источник: https://medium.com/@copyconstruct/monitoring-and-observability-8417d1952e1c

Такое ощущение что новые термины, новые специализации, новые продукты вокруг этих терминов и явлений появляются в области работы с данными чуть ли не ежемесячно. Data Observability (Наблюдаемость данных) - это термин о котором пишет Barr Moses из стартапа Monte Carlo. Смысл термина в том, что это одно из измерений качества данных связанное с мониторингом доступности источника данных, мониторингом поступления данных и того что все процессы по их обработке, переносу, обогащению и загрузке работают как ожидается. Иначе говоря - это измерение того насколько Ваши процессы работы с данными измеримы и наблюдаемы. Автор явно увязывает этот термин с другим термином Data Downtime (Недоступность данных), опять же относящемуся к наблюдению за источниками данных и отслеживанию когда в потоке данных возникает неполнота, ошибки и так далее.

На мой взгляд оба термина более чем имеют право на существование, и относятся, как к инженерии данных (data engineering), так и к качеству данных (data quality).

Государство - это формы

Кто-то скажет что государство - это органы власти. Но ведь это как посмотреть, для гражданина - это то с чем он сталкивается, люди, процессы и, бумаги:

Одна из самых слабых сторон цифровизации/автоматизации/электронизации государства в России - это полное отсутствие или ужасающее состояние G2G сервисов, иначе говоря услуг и сервисов которые органы власти не _обязаны_, а могут использовать.

Один из лучших примеров G2G сервисов - это FormSG, сервис построения форм для заполнения гражданами, бизнесом, госслужащими. Вместо того чтобы выдавать гражданину форму на получение пособия, гранта, заявления и так далее, он имеет возможность заполнить её онлайн через этот сайт. А государственные служащие, соответственно, имеют возможность создавать эти формы, их менять, получать заполненными и обрабатывать.

Сервис очень похож на Google Forms или SurveyMonkey, но в данном случае именно государственный сервис более чем оправдан частотой необходимости заполнения форм и интеграцией с государственной системой аутентификации.

За всё время сервисом воспользовались 44 856 госслужащих для создания 47 402 форм которые были заполнены 59 265 326 (59 миллионов раз!).

Каждый раз когда я вижу какую-либо очередную бумажную форму которую надо заполнять в России, я вспоминаю именно про FormSG и задаюсь вопросом “Почему Россия не Сингапур?“.

И, конечно, Form.sg доступно с открытым кодом и, теоретически, ничто не мешает Минцифры России добавить этот сервис к порталу Госуслуг.

Работа учёных с данными

Современные ученые, даже в нетехнических науках, работают с данными значительную часть их работы над публикациями и иными научными продуктами.

“Рынок“ работы с данными исследователями можно разделить на несколько ключевых направлений:

коммерческие продукты дающие возможность публикации данных исследователями (Data.world, Mendeley, Figshare и многие другие)

проекты по публикации данных университетских и научных консорциумов (Dataverse, OSF, Zenodo)

государственные инициативы в виде специальных архивных центров по созданию инфраструктуры архивации и доступа к научным данным (UK Data Service, DANS)

государственные-научные инициативы по доступности чувствительных данных для учёных, пример, проект Odissei в ЕС, основнном на доступе к данным по каждому домохозяйству и каждому человеку участвовавшему в переписи в Нидерландах.

Ещё в начале года я проводил анализ того какие сервисы работы с данными создаются государствами, можно на Slideshare презентация с обзором и выводами.

Ключевая разница между частными и государственными проектами в этой области в том что частные проекты делают сильный акцент на своих технологических платформах, а государственные на правилах, тренингах, консенсусе, правилах и тд. в работе с данными.

Пока всё идёт к тому что продукты и проекты в этой области ,будут иметь строгую отраслевую привязку и проще поверить в появление десятков платформ по разным областям научных знаний чем в одну-две объединяющих всё вместе. Слишком много существенных отличий в инструментах которе нужны генетикам, астрофизикам, социологам и тд. Платформы работы с данными обретают большую ценность когда эта специфика учитывается.

Заметки

видно что чрезвычайно популярная бизнес модель по облачным и корпоративным data pipelines, можно сказать один из самых очевидных видов сервисов которых уже десятки если не сотня. Есть ощущение что это уже “красный океан“ и, в то же время, есть ощущение что вот эти решения по мониторингу исполнения потоковых задач транслируемы на другие области, такие как веб архивация (но тут почти нет денег в рынке)

мне лично очень интересно можно ли автоматизировать многие задачи работы с данными. Например, автодокументирование или автоидентификация структуры и схемы данных, автоматическое извлечение через “познание” логики и структуры источника данных, автоматическое построение data pipeline и так далее. Я давно думал и тренировался на превращениях “сайт-в-данные“, “база-в-api“ с минимальным участием человека, но универсального решения пока нет.

Ссылки

Public AI Registers методический документ по обеспечению прозрачности систем искусственного интеллекта.

Introducing ThirdEye: LinkedIn’s Business-Wide Monitoring Platform статья в блоге LinkedIn Engineering в 2019 году о их внутреннем продукте ThirdEye по поиску аномалий в данных.